A imagem que ilustra o post de hoje foi gerada pela Dall-E, a inteligência artificial da OpenAI que gera imagens a partir de descrições textuais. Seu irmão mais badalado – por ora – é o ChatGPT. E você pode ter um gostinho de como é falar com ele através deste link: Bing.com (no topo, clique em “chat”). Tire suas próprias conclusões.

Este claramente é um post que poderia ser dois. Ou três. Mas, como eu não ganho nada com mais ou menos views, mais ou menos cliques, aqui está o conteúdo inteiro, de uma vez. Leia com a paciência que tiver e obrigado, desde já, por tentar chegar até o fim.

Aviso (disclaimer): preciso avisar ao leitor e à leitora que eu sou empregado da Microsoft. Sim, aquela do Windows. Sim, também aquela do ChatGPT (graças à parceria com a OpenAI). Todas as opiniões ora redigidas são de minha autoria e somente de minha autoria. Meus gerentes, diretores e demais superiores hierárquicos JAMAIS solicitaram ou sequer foram consultados sobre o conteúdo que aqui se veicula, tampouco têm qualquer interferência (contributiva ou restritiva) nas palavras e ideias que enfileiro daqui em diante.

O autor do post, Rodrigo

Finalmente, aos que são da área técnica: simplificações serão feitas em prol da clareza e do acesso ao tema debatido. A ideia por aqui é escrever “Sobre Tudo e Sobre Todos”, mas sempre escrevendo “para todos”.

Ahhh… Relaxante como correr num campo minado… Essa é a tarefa de falar a sério de um tema controverso, polêmico, que faz “buzz”, que é “hype” (os antigos [ = gente que ainda fala português no Brasil] diriam: “está na moda”), em que sua empregadora é uma das principais expoentes e patrocinadoras das novidades e avanços; tudo isso, tentando manter a isenção e, ao mesmo tempo, o emprego… Não vai ser fácil, mas eu acredito no lema que vai insculpido na bandeira da minha nação: “mais sorte do que juízo” … Vamos começar pelo básico.

Tudo começou há um tempo atrás, na ilha do… Homero!

A humanidade sonha com o atingimento de “A” inteligência artificial (IA; ou “AI”, em inglês) faz um tempinho, tá? Eu sei: meu público é qualificado e a maioria vai chutar algo em torno da década de 1940, fim da 2ª grande guerra, Alan Turing, pai da moderna computação e coisa e tal; e, grosso modo, estarão certos. Mas, eu sou um #@%& e é claro que não vou ficar no trivial.

Possivelmente, a primeira citação que se tem notícias quanto ao sonho humano sobre IAs vem da Grécia antiga (CLARO… Tinha que vir de lá…).

Hefesto, filho de Zeus com Hera é, portanto, um deus. Deus dos ferreiros, dos escultores, dos metalúrgicos, do fogo e dos vulcões, ainda é o deus da tecnologia segundo a Odisseia de Homero. É Hefesto que tem o dom de “dar vida” a criaturas de metal que ele mesmo constrói. Olha aí! Robôs! Autônomos! Vivos! Na Grécia antiga! Aquele pessoal tinha um tempo livre absurdo pra ficar inventando essas coisas… Bem melhor é hoje em dia, que não temos tempo pra pensar em nada além das contas pra pagar… ahem… Continuando…

Portanto, podemos conjecturar (sem muito apoio bibliográfico, admito) que quando o primeiro homem foi capaz de dobrar o metal e criar ferramentas, e que quando nasceram os primeiros mecanismos rudimentares, frutos da inventividade humana, este sujeito já deveria ter considerado: “rapaz, seria bom se esse negócio fizesse o serviço sozinho…”.

A cultura pop do século XX e XXI fez o favor de solidificar o nosso conceito plural do que deve ser uma IA: máquinas que simulam a inteligência de pessoas, que superam pessoas, que têm ideias originais, próprias, que resolvem problemas para os quais não foram treinadas anteriormente (considerando seu código original). E que, eventualmente, matam todos nós ou nos escravizam para usar como bateria (ah, que filme maravilhoso… Pena que decidiram destruir essa relíquia com a mais recente “continuação” [esculhambação]).

De Isaac Asimov e sua literatura definidora do subgênero em “Fundação”, “Homem bicentenário” ou “Eu, Robô”, passando por clássicos da tela como “2001: Uma odisseia no espaço”, “Blade Runner”, o inesquecível arco de “Exterminador do Futuro”, “A.I.”, “Homem Bicentenário”; chegando aos dias mais atuais com “Matrix” (esse filme merecia um post só seu, de tanto que eu gosto dele), “Eu, Robô”, “Ex Machina”, “Chappie”, (o ruim) “Transcendence”, e o belo e triste “Her” (se não viu, veja: Joaquin Phoenix, pra variar, brilha…). Dá até pra falar em “Vingadores: Era de Ultron”, por que não?

E como esquecer de “Chuck, o boneco assassino”? Claro: podemos nos questionar se um boneco que ganha vida e vontade (assassina) própria, por efeitos de magia negra e satanismo, seria um representante da IA na ficção, mas hey! Eu não estou aqui para julgar…

Uma coisa é certa: a depender da ficção, nós deveríamos saber que mexer com I.A., 99% das vezes, leva ao nosso ocaso (que palavra bonita, né? Quer dizer “f#@eu pá nóis”…). As IAs das telas e livros logo percebem que seus criadores são uns Zé-ruelas (eu sei… é “arruela”, mas não soa tão bem) e dão um jeito de nos matar enquanto dormimos. Ou criam gigantescos exércitos para nos matar acordados, mesmo. Quem não gosta de um sadismo? Em outros casos, elas matam metade e ligam a outra metade em baterias high-tech & high-terror®™©.

Medo. Medo primitivo. É isso que este subgênero da ficção quase sempre desperta em nós. Criatura matando criador. Um tipo de mito que os gregos de outrora conheciam e exploravam bem. Os cristãos também (se considerarmos que Jesus forma a trindade com Deus e o Espírito Santo, e que, mais tarde, a criatura crucificou o filho do Criador [que também é Um com o Criador] … Porém, isso fica pra outro dia…).

Há algumas exceções, claro. “I.A.” e “Homem bicentenário” usam a IA como pano de fundo para falar de sentimentos, como a necessidade de validação do indivíduo, o desejo de ser amado, e tentam inquirir o que move todo ser que é consciente da própria existência (até mesmo um robô). Exploram o que acreditam separar “homem” e “máquina”: os sentimentos e consciência da existência deles e de seus efeitos.

“Her”, igualmente, alegoriza a IA para falar da solidão profunda de alguém que não encontra conexão com nenhum ser humano, até que a IA o entende de um jeito tão pleno que ele não pode mais viver sem seu amor, baseado em silício (é basicamente disso que chips de computador são feitos).

Há obras “alto astral” sobre IAs. Eu não as li, mas o grande amigo Aloisio sempre faz propaganda de Iaim M Banks e sua novela chamada “Cultura”, composta de 10 livros lançados entre 1987 e 2012. “Consider Phlebas” inaugura esse arco. Na obra, se propõe que fomos capazes de criar uma tecnologia de IA que atingiu a ora sonhada, ora temida, “singularidade”. “Singularidade”, termo emprestado da física para dizer que se chegou num grau de algo em que não mais se pode mensurar ou compreender o evento pelas lentes da ciência que temos. Atingir “singularidade”, em IA, significa que a criatura ficou tão complexa e perfeita que seu criador (nós) não é capaz de dizer até onde ela vai e o que pode fazer (de bom e de mau).

Ao atingir a singularidade, a IA de Banks construiu uma utopia (o oposto de “distopia”; na primeira, todo mundo é feliz) para a raça humana, levando nossa espécie a uma Era de pós-escassez (outro conceito difícil de explicar sem escrever uma bíblia, mas saiba que a economia da nossa época é inteiramente baseada na ideia de escassez. Num mundo “pós essa parada”, tudo existe em quantidade superior ao que precisamos. Tudo: de água potável a bens de consumo variados).

Então, aqui estamos. Este é o arcabouço (palavra bonita para “uma pá de ideias reunidas”) construído ao longo do fim do século XX e começo do XXI sobre IA: ela só é IA quando a máquina consegue fazer tudo o que fazemos, igual ou melhor. E, geralmente, ela bota no orifício rugoso do criador dela… E a gente morre. Ou vira pilha. Ou, se apaixona e acaba corno da Siri. Sei lá…

É isso que o ChatGPT é? Ele é melhor do que nós? Ele sabe mais? Ele é livre para decidir o que vai fazer a seguir? Ele vai botar no nosso mais querido esfíncter, dentre os mais de sessenta que o corpo humano tem?

Quem sabe? Ahem… Seguindo…

Não é IA (ou, pelo menos, não é o que as pessoas esperam que seja) …

Eu não disse? Relaxante como alimentar leões, usando uma roupa feita de bifes crus…

Quando eu te pergunto “o que é Inteligência Artificial?”, eu tenho um grande grau de confiança que você vai me responder algo na linha “é um computador que pensa como um humano”. A resposta pode ser mais ou menos elaborada, mas o teor é esse. Afinal, foi o que o nosso repertório de cultura pop construiu pra todos nós, certo?

Pois é… Eu venho aqui para chatear você. Sob algum rigor científico, aquilo que tem gerado milhares de manchetes não é essa IA que 99% das pessoas têm em mente.

Não estamos lá, ainda. E, sim: eu entendo que isso é bem polêmiquinho. O jornalista chama de IA, o fabricante chama de IA, o filme chama de IA. Tá tudo mundo errado e o Zé das Couves (a.k.a. “Rodrigo”) tá certo? Bem, se você me acompanha há algum tempo, sabe que não falo sem mostrar de onde vêm meus argumentos. Não vai ser diferente hoje, aguenta aí.

Ah, eu não sou cientista da computação, ok? Eu cursei Processamento de Dados (tecnólogo), depois me graduei Gestão de Tecnologia da Informação (idem) e, depois, me especializei em Gestão de Pessoas (Pós, lato sensu). Mas não sou bacharel em Ciências da Computação. Importante não deixar nada subentendido em assuntos espinhosos. Não quero me portar como autoridade no tema. A qualidade do meu argumento e as fontes “em que bebo” devem fazer (ao menos em parte) esse trabalho.

John McCarthy, pesquisador do departamento de Ciências da Computação da Universidade de Stanford (uma das instituições mais prestigiadas do mundo, nesta [e em outras] área de pesquisa), publicou o seguinte artigo, em novembro de 2007: “What is Artificial Intelligence?”. Você também pode lê-lo aqui, em inglês. Ele inicia dizendo que o texto visa responder às perguntas dos leigos e que as visões apresentadas ali não são consenso na área. Como eu, John também devia ter preocupações ao andar nesse terreno feito de areia movediça.

Em suas 15 páginas, o autor apresenta diversos conceitos e ramos da IA, mas ele sumariza o conceito do que acredita ser IA logo na página 2, e da seguinte forma (que já vai livremente traduzida por mim):

É a ciência e a engenharia de fazer máquinas inteligentes, especialmente programas de computador inteligentes. Está relacionada à tarefa semelhante de usar computadores para entender [e replicar] a inteligência humana, mas a IA não precisa se limitar a métodos que são biologicamente observáveis.

fonte: link acima, pág. 2; adição de palavras minhas, em colchetes.

Ok… Mas se IA é “a ciência e a engenharia de fazer máquinas inteligentes”, precisamos definir o que é “inteligência”, certo?

E para não causar um grave problema que pesquisadores de primeira viagem tendem a cometer, é importante se esforçar para achar a definição do termo em foco dentro do conteúdo produzido pelo mesmo autor, ou buscar em conteúdo que aquele utilizou para fazer a sua pesquisa. Na pior hipótese, recorrer ao material feito por pesquisadores que se basearam no autor do argumento original para produzirem suas pesquisas. Caso contrário, a polissemia (palavra difícil para “muitos sentidos numa mesma palavra”) pode levar a construções de raciocínio para as quais o autor original jamais quis construir (porquanto não compartilhava da definição do termo dada por outra fonte).

Então, John define inteligência na mesma pág. 2, da seguinte forma (de novo, tradução minha [ = t. m.]):

A inteligência é a parte computacional da capacidade de alcançar objetivos no mundo. Vários tipos e graus de inteligência ocorrem em pessoas, muitos animais e algumas máquinas.

ibid.

Ok, portanto, para McCarthy, inteligência é a “capacidade de alcançar objetivos no mundo”. Veja, o autor não especificou que tipo de “objetivos” seriam esses. Aqui, a coisa começa a ficar complicada. Se eu desenvolver um martelo automatizado por computador e que prega pregos em qualquer superfície em que um prego seja pregável, haverá inteligência no martelo, posto que “alcançou-se o objetivo”? Sei que reductio ad absurdum sempre soa mal (deu vontade de falar em HarryPotternês) mas, a mim, fica evidente que se um computador simplesmente “atinge objetivos” não estamos diante de “inteligência”. Pelo menos, não da inteligência que se espera da “tal IA”. Computadores “atingem objetivos” o tempo todo, desde sempre.

Não quero, com isso, desqualificar o artigo do autor, que achei instrutivo, elucidativo e válido. Ele escreveu para um público leigo e esse é um importante – e um tanto raro – esforço da Academia em se conectar com as pessoas que não estão lá, no dia a dia.

John responde a uma pergunta que considero crucial para compreender onde estamos no assunto “IA de verdade”, à pág. 3. A pergunta é a seguinte (t. m.): “A inteligência é uma coisa única para que se possa fazer uma pergunta do tipo ‘Esta máquina é inteligente ou não?’?”.

E a resposta é (t. m.):

Não. A inteligência envolve [muitos] mecanismos e a pesquisa em IA descobriu como fazer os computadores executarem alguns deles e não outros. Se a execução de uma tarefa requer apenas mecanismos que são bem compreendidos hoje, os programas de computador podem oferecer desempenhos impressionantes nessas tarefas. Tais programas devem ser considerados ‘um tanto inteligentes’.

Ibid. Adição de palavras minhas, em []s.

Ou seja: a forma como os pesquisadores encaram “a medida de inteligência” é uma forma racional – porém, muito limitada diante do conceito lato sensu (e, talvez, equivocado) – e que mede a “competência” (performance) de programas em realizar tarefas. Tarefas para as quais o campo de IA já compreendeu razoavelmente bem os mecanismos de inteligência (humana), necessários à sua execução.

Mais do que isso, John discorrerá que o campo de pesquisa da IA pode até perseguir a simulação da inteligência humana em máquinas, mas que a maioria dos pesquisadores não está focado numa tarefa tão difícil e complexa e para a qual o campo de pesquisa nem consegue descrever e explicar todos os mecanismos necessários para ela. Não é sobre a velocidade das máquinas, não é sobre o futurismo das metas. É sobre nem saber como codificar o mecanismo de inteligência que nós, humanos, usamos para resolver os N problemas e questões com que nos deparamos, muitas vezes, de forma inédita. Nós ainda não sabemos como ensinar a máquina a pensar da forma como nós pensamos. Pelo menos, não de modo amplo e irrestrito. Nem sabemos se esse é o melhor caminho para chegar em “A IA”.

O artigo é de 2007, então vamos dar um pulo numa opinião de alguém em 2023.

IA, Machine-learning, LLM… A sopa de letrinhas…

Michael Wooldridge é um dos coordenadores de pesquisas sobre IA na prestigiosa Universidade de Oxford; tem uma cacetada de artigos na área e lançou, em 2021, seu livro “A Brief History of Artificial Intelligence” que não tem um enfoque tão técnico, mas tenta sumarizar os avanços da pesquisa científica na área, com foco no grande público.

Em seu artigo mais recente, de maio de 2023 – e que você pode ler aqui (inglês) – ele argumenta acerca dos avanços e frustrações daqueles estudando IA, e não deixa de endereçar sobre o que pensa no tema do momento, o ChatGPT, e o quanto essa tecnologia é “true AI” (uma “IA de verdade”).

Adianto que acho complicado esse negócio de “IA de verdade”. Mais uma vez, precisamos definir o que é “inteligência” e se aceitamos graduações nessa escala, para dizer, finalmente, se aceitamos que o ChatGPT “chegou lá” ou não; seja lá onde “lá” fica nessa escala.

E, como venho dizendo, escrever este post – visando manter a isenção e o emprego – tem sido muito relaxante. Relaxante como ser forçado a usar um submersível da OceanGate para ver um navio afundado e que não significa nada para mim… Seguindo…

Então, Michael explica um pouco de sua frustração (t. m.):

Neste ponto, há algo que simplesmente preciso desabafar. Graças ao ChatGPT, finalmente chegamos à Era da IA. Todos os dias, centenas de milhões de pessoas interagem com a IA mais sofisticada do planeta. Isso levou 70 anos de trabalho científico, inúmeras carreiras, bilhões e bilhões de dólares em investimentos, centenas de milhares de artigos científicos e supercomputadores de IA funcionando em alta velocidade, por meses. E a IA que o mundo finalmente obtém é… um autocompletar [de textos, como aquele do seu celular].

No momento, o futuro de empresas de trilhões de dólares está em jogo. O destino deles depende de… um autocompletar.

fonte: link acima. Adição de texto meu, para clareza, entre []s.

Hahaha! Eu juro que ri muito quando li essa parte do artigo… Eu prefiro pensar que, como eu, Michael é um cara que curte sarcasmo. Não quero crer que ele seja amargo ou invejoso e não tenho motivos para pensar assim, porque a carreira dele vai bem, obrigado.

A visão de Michael sobre o ChatGPT não é assim tão simplória, conforme ele finaliza em seu artigo (t. m.):

Isso não significa que elas [as tecnologias LLM, como o ChatGPT] não sejam impressionantes (elas são) ou que não possam ser úteis (elas são). E eu realmente acredito que estamos em um momento decisivo na tecnologia [de IA]. Mas não vamos confundir essas conquistas genuínas com a “verdadeira IA”. As LLMs podem ser um ingrediente na receita da verdadeira IA, mas certamente não são a receita completa – e suspeito que ainda não sabemos quais são alguns dos outros ingredientes [necessários para a “IA de verdade”].

Ibid. Adição de termos meus, para aumentar a clareza, somente nos colchetes. Aspas e parêntesis no original.

Calma, para… LLM? O que que é isso? Pois é… A área de TI tem dois tipos de profissionais: os que fazem as coisas acontecerem e os que inventam nomes e siglas (tô de brincadeira. Mas, não muito).

Machine Learning

Vamos começar com machine learning e como isso não é “A IA” (mas importa para ela):

Segundo o departamento de pesquisas em IA da Universidade de Columbia (notaram que não estou citando qualquer fonte “corporativa”, certo?), machine learning (t. m.):

O aprendizado de máquina [ = machine learning] é um caminho para a inteligência artificial. Essa subcategoria de IA usa algoritmos para aprender insights [descobertas] automaticamente e reconhecer padrões de dados, aplicando esse aprendizado para tomar decisões cada vez melhores.

fonte: link acima

Então, machine learning [m. l.] é uma forma de criar algoritmos ( = códigos que formam programas de computador) que visam “aprender” com base no que já conhecem, ou com base na interação que têm com os dados e resultados colhidos para, em momento posterior, decidir com base nas experiências e resultados passados.

Até por isso, “aprendizado de máquina” parece o jeito mais preciso de traduzir o termo. A máquina (na realidade, o programa de m. l., executado em um computador) recebe dados de várias fontes (e.g.: bancos de dados, arquivos, resultados de outras execuções e interações) e tenta reconhecer padrões de resposta, conexões entre os resultados, os retornos para essas respostas (certo/errado, sucesso/falha) e se prepara para ser mais rápido, mais correto, mais preciso […] na próxima vez em que aquele “caminho de decisão” precisar ser percorrido.

De certa forma, isso emula o jeito com o qual aprendemos com as lições passadas. Tentamos e, se dá certo, registramos como uma resposta (ou jeito de fazer) acertada. Se falha, deveríamos – nem sempre aprendemos – propor uma nova forma de fazer ou responder àquilo.

Mas isso é inteligência? Olhar para o passado e prever a melhor resposta para o futuro? Certamente, isso é parte da nossa inteligência. Mas não é “A” inteligência. Aliás, sem uma interface, como um programa LLM conectado a um sistema de machine learning, não há como qualquer um “falar” com este sistema sem conhecer linguagens especificas de computador. A resposta de McCarthy que nega uma definição única de “inteligência” faz mais e mais sentido.

Neural Networks

Depois, temos (artificial) neural networks ou “redes neurais (artificiais)”. Isso é fundamental para falarmos de LLM porque é “a memória e o processamento” com os quais LLMs, como o ChatGPT, são executados.

O conceito de redes neurais, como Wooldridge explica em seu artigo, não é nada novo. Baseado nos conhecimentos de biologia e neurociência, foi proposto em meados de 1940, mas teve sua maior evolução nas décadas de 1960 e 1980. Grosseiramente, redes neurais simulam o comportamento dos neurônios em nosso cérebro, ligando uma série de equipamentos informáticos em teias (como nossos neurônios!). Segundo o autor, os atuais avanços das redes neurais não foram muito além dos conceitos centrais que já se propunha em 1980, embora ele reconheça um avanço substantivo nos algoritmos e estruturas de configurações dessas redes. O que realmente mudou, para ele, foi a escala.

Ele aponta que primeiro programa inteligente, capaz de vencer uma partida de Go (para ficar no simples: uma espécie de xadrez, principalmente jogado no leste asiático) contra um campeão mundial (humano) ocorreu em 2016. O AlphaGo, feito pela DeepMind, venceu em março daquele ano. Esse software era apoiado por duas redes neurais com 12 camadas neurais, cada. Em termos de parâmetros da rede neural, o AlphaGo tinha cerca de 4.6 milhões de parâmetros, conforme o artigo de Mitsuru Igami, pág, 14, publicado pela Miami University. Esses parâmetros podem significar um “neurônio artificial” (um pequeno computador, especializado para este tipo de rede) ou a conexão entre esse “neurônio” e outros.

A tecnologia GPT-3, que atualmente é o motor do ChatGPT, aberto ao grande público, tem 175 BILHÕES (isso mesmo: bilhões) de parâmetros no total. Para o GPT-4, a tecnologia que ainda não está ao acesso de ninguém fora do círculo de desenvolvimento, esperam-se 1 TRILHÃO de parâmetros. Isso é o sentido de “escala” em que Michael fala.

Ainda segundo Michael, o GPT-3 foi treinado com 575 gigabytes de texto, pouco mais de meio terabyte. E enquanto você pode achar que isso não é impressionante, já que é comum termos máquinas em casa com discos rígidos (HDs, SSDs etc.) de 1 terabyte ou mais, considere que estamos falando dum tipo de dado dentre os que menos ocupam espaço: texto. Este gigantesco texto que escrevo, aqui, em sua versão Word (que nem é a mais econômica em espaço, posto que tem formatação, metadados e tal), tem apenas 50 kilobytes de tamanho. Tem noção dessa dimensão? 1 terabyte são 1024 gigabytes. 1 gigabyte são 1024 megabytes. 1 megabyte são 1024 kilobytes. Este texto = 50 kilobytes. Ainda acha 575 gigabytes de texto puro – e possivelmente comprimido – “pouco”?

Então, essa incrível rede neural de 175 bilhões de parâmetros (na versão 3) recebe um treinamento via algoritmo baseado em machine learning, num conteúdo gigantesco de texto, e isso dá vida ao ChatGPT que é um LLM. Tem, ainda, a questão das pessoas que foram usadas para treinar o ChatGPT; é um assunto polêmico por si só, eu não tenho condições de abordá-lo hoje, mas fica aqui o registro de que sei dessa dimensão da problemática toda. Estamos prontos para falar do que é o ChatGPT, rusticamente.

O que é um LLM? O que é o ChatGPT?

LLM é a sigla para “Large Language Model”. Ou “grande modelo de linguagem”, numa tradução livre.

Legal… E daí?

E daí que esse é um jeito de codificar um programa para que ele compreenda textos da forma como nós falamos. Ele tem noções de linguagem humana, como uso de preposições, adjetivos, verbos[…]. Ele sabe como combiná-los e sabe como extrair sentido disso.

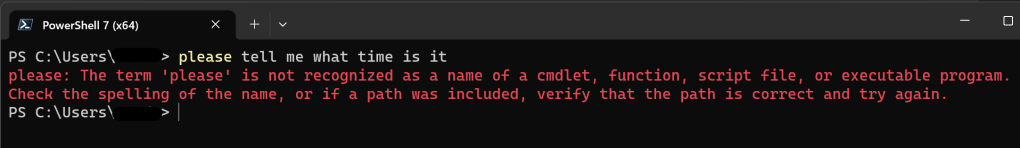

Se eu te disser “você tem horas?”, eu não preciso te explicar, no detalhe, que não quero saber se você é detentor da informação chamada “horas”. Você sabe que estou dizendo “por favor, me informe o atual horário oficial de Brasília, GMT -3”. E esse sempre foi o desafio com programas de computador, no geral. Ao criar o código, eu, programador, tenho que considerar todas as formas e meios tidos como válidos para que o usuário (você) interaja com o programa. Se eu não criar um pedaço do código do programa para entender “você tem horas?” como “informe a hora atual do local do usuário”, o programa não sabe o que fazer com esse pedido. Ele vai, possivelmente, emitir um erro como “comando não reconhecido”, ou coisa que o valha.

Portanto, até esse momento da história, nós, humanos, aprendíamos a linguagem da máquina: como perguntar as horas, como iniciar programas, qual comando digitar (ou botão a apertar) para reiniciar o computador… Já as LLMs falam a nossa língua. Pelo menos, em boa medida.

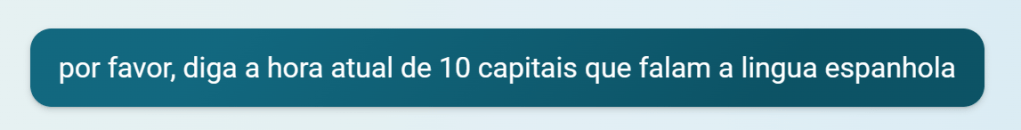

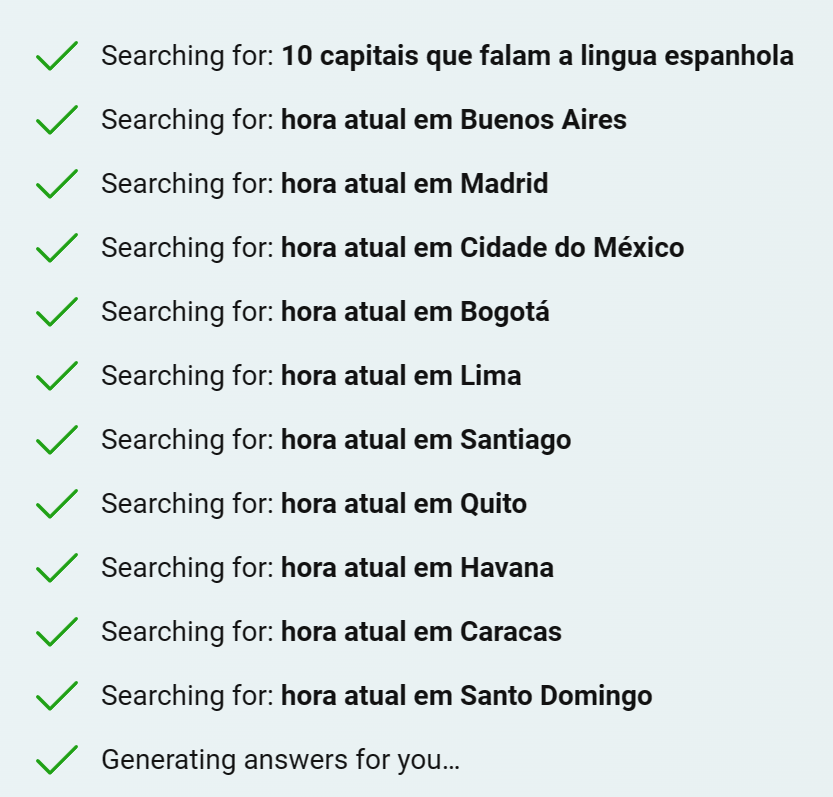

Você pode ir ao ChatGPT e escrever “por favor, me informe a hora atual em 10 capitais mundiais onde se fala espanhol” e ele vai te responder. Ninguém codificou o “programa” ChatGPT para lidar com o comando “informe horas + 10 capitais do mundo + em que se fala espanhol”. Ele não estava previamente preparado para responder isso, mas ele “sabe” – porque sua rede neural e seu aprendizado de máquina já revisaram 575 gigabytes de texto, mais o treino feito com humanos – o que você quer dizer com “10 capitais” (o que são capitais? Quantas existem?) que falam espanhol (o que é “falar”? Que línguas existem? Como “espanhol” qualifica “falar”?), e o horário atual nelas (qual a hora atual, em cada uma das 10 capitais arbitrariamente escolhidas pelo programa?). Esse é o brilhantismo de um software executando um Large Language Model. Ele entende o que você fala sem que o programador precise ter escrito um pedaço de código para entender CADA possibilidade e jeito de se perguntar uma informação (certamente, há mais de um jeito de perguntar a hora atual em 10 capitais onde se fala espanhol. Em mais de uma língua, inclusive – e o ChatGPT saberá responder em, virtualmente, 100% dos casos).

E, por trás dos panos, os componentes da rede neural do ChatGPT estão falando a língua das máquinas. Por exemplo, em Powershell (uma linguagem de prompt que o seu Windows 10 e 11 tem aí) você poderia executar: “[System.TimeZoneInfo]::ConvertTimeBySystemTimeZoneId([DateTime]::Now,”Romance Standard Time”)”

… para saber a hora em Madri. O ChatGPT fará algo parecido (obviamente, é mais escalável e sofisticado do que abrir um prompt e executar um comando), depois de determinar que Madri é uma capital onde se fala espanhol. E fará o mesmo com outras nove capitais que atendem ao critério.

A resposta que ele vai te dar também é diferente do que um programa comum faria. No prompt do Windows, o comando, acima, gera uma linha de resposta “seca”, padronizada, assim: “Saturday, June 3, 2023 8:48:16 PM”. Mas, o ChatGPT vai te apresentar um texto como se fosse escrito por outro ser humano. Algo dizendo “As 10 cidades que falam espanhol foram x, y, z, […]. Os horários atuais para cada uma delas são x = a, y = b, z = c…”

Ao olhar o texto, você tem dificuldade de imaginar que um programa de computador criou uma resposta daquelas em segundos e uma resposta personalizada, única, e que vai ser diferente se outra pessoa perguntar de outro modo. Porque realmente fica parecendo que “tem gente” digitando a resposta do outro lado.

Mas, isso é IA?

Bem, certamente há uma capacidade cognitiva aí e que podemos chamar de “inteligente”. O programa não foi previamente codificado para pedidos tão diversos como “as horas em 10 capitais de língua espanhola” ou “me dê receitas de bolo trufado que não levam ovos”, ou “faça um resumo das causas prováveis para o início da 1ª guerra mundial” e, ainda assim, ele consegue responder a todos eles. Mais do que isso: se você fornecer um texto de sua autoria e pedir para que o ChatGPT o refine para linguagem formal ou crie um resumo, ele é capaz de fazer essas tarefas e de todos os modos o seu programador não precisou criar cada uma das normas cultas, de cada uma das línguas suportadas (e ele suporta uma enorme quantidade de línguas) para que o ChatGPT pudesse fazer isso.

No entanto, se eu pedir ao ChatGPT que “me ajude a montar um helicóptero em casa”, ele vai me dizer que “isso é muito difícil” e que tem empresas que vendem kits para que aventureiros tentem montar helicópteros rudimentares, mas que, ainda assim, eu tenho que ter muito conhecimento em engenharia e centenas de horas disponíveis para essa tarefa. Bem diferente do Jarvis que quando ordenado pelo Tony Stark a fazer um traje do Homem de Ferro novo, o faz e não fica inventando desculpinhas para fugir da tarefa (contém sarcasmo. E nerdice.).

Do mesmo modo, se eu pedir para que o ChatGPT reconstrua toda a sua identidade visual para se apresentar a mim em tons que lembrem o filme “Matrix”, ele não vai conseguir cumprir essa ordem. Alegará que é apenas um assistente virtual e que não tem controle sobre a interface gráfica (web) do chat.

Oras, então, se eu lhe perguntar “eu tenho um barco que voa para o céu, mas um pneu fura. Quantas laranjas sobram?” a resposta também não vai ser muito boa, certo?

Os LLMs estão até começando a entender sarcasmo, mas “nonsense” (ou “comédia do absurdo”) ainda não é algo que a plataforma interpreta bem. Isso porque o modelo de interpretação de linguagem que o GPT-3 implementa pressupõe estabelecer algum contexto lógico naquilo que foi dito ao programa.

Resumindo, o ChatGPT não é “inteligente” como as pessoas – no geral – imaginam que ele seja. Ele não pode te ajudar a construir uma bomba atômica, por exemplo – até por políticas de segurança que seus programadores certamente codificaram em suas “travas”. E mesmo que ele soubesse como fazer, ele só te responderia com textos e links. Se tiver um vídeo por aí de “como fazer uma bomba atômica em casa”, ele te mandaria o vídeo (mas não vai, porque dirá que não deve fazer nada de mau e que nukes causam danos e morte, e por aí vai.).

Do mesmo modo, se eu pedir que o ChatGPT recodifique a si mesmo para que sua janela de chat lembre o antigo ICQ, ele também não vai fazer isso porque não é livre para se reconstruir e para mudar suas funções pré-codificadas, ou para reinventar tudo o que o faz ser o programa que é. Ele aprende com as interações, ele consome novos textos, ele aprende a ter respostas mais precisas. Mas o LLM “ChatGPT” não vai se tornar outra tecnologia por conta própria.

Se eu pedir que ele edite um arquivo de vídeo para mim, ele dirá “eu não consigo” e não chegará o dia em que “cansado” de receber esse tipo de pedido, ele criará – por conta própria – uma nova seção em sua interface onde eu posso mandar um arquivo mp4 e ele me devolva esse arquivo com as alterações que eu pedi.

A importância de não julgar o peixe pela sua habilidade de subir em árvores

Outra grande bobagem que vejo por aí é gente aplicando escala de QI para medir o ChatGPT ou qualquer outra IA. Por mais midiático que isso possa vir a ser, não há qualquer sentido prático em utilizar uma escala feita para medir um dado aspecto (o lógico) da inteligência humana em crianças, para medir a “inteligência de uma máquina” (dentro do limitado contexto do que estamos chamando de “inteligência”).

Se eu pergunto para uma criança quais os 15 números após a vírgula da constante de Pi, e ela os recita sem sofrimento, sua memória é incrível. Se eu medir isso em computadores, eles guardam números em sua memória desde sempre. Não há nenhum desafio para eles. Também, isso não demonstra nenhuma inteligência por parte deles.

É como dizer para o Mike Tyson “você até que bate forte, mas não é nada comparado à porrada de uma retroescavadeira que usa luvas de boxe gigantes ao invés da pá!”. Escalas são desenhadas para grandezas comparáveis. Medir a “inteligência” do GPT, ou qualquer IA, usando uma escala de QI é inútil e serve, no máximo, para render material de publicidade.

Afinal, a criança que lembrar dos 15 números após a vírgula do Pi pode muito bem vir a construir supercomputadores no futuro (ou descobrir a cura do câncer, ou passar o dia sem fazer nada.). Mas o ChatGPT, limitado a responder perguntas e respostas com base nos virtualmente infinitos textos ao qual foi e é apresentado, não vai construir computador algum durante sua existência (ele não tem braços! Ele não tem codificado, em si, os mecanismos de inteligência necessários para montar as placas eletrônicas de um computador, ainda que lhe dessem braços. Ele sabe como interpretar falas “naturais” nossas e responder com a mesma desenvoltura e é isso… E só isso. E é tudo isso.).

Então, o ChatGPT não apresenta qualquer risco para a sociedade? Os alertas de várias partes, incluindo pesquisadores da área, são “histeria”? Fim?

Não.

IA, o fim do mundo e “um dinheiro para todos governar” (e na escuridão aprisionar)

Ah… Relaxante como andar com a camisa do Lula no interior de Santa Catarina…

Eu preciso frisar algo fundamental aqui: tudo o que eu escrevi aqui e que sigo escrevendo – exceto às citações aos trabalhos dos pesquisadores mencionados – é fruto da minha opinião. “Opinião” é a interpretação pessoal de um fato. E um fato não pode ser uma opinião. Opinião é subjetiva ( = varia de acordo com os sujeito). Fato é objetivo. Fato não depende de interpretação. Se estão te dizendo que tudo é relativo ou subjetivo, estão te enganando ou tentando enganar e lamento que você esteja passando por isso.

Assim, temos alguns fatos; e eu tenho opiniões, análises, interpretações sobre estes fatos. Para garantir que NINGUÉM tenha dúvidas do que são fatos e opiniões eu os separo, categoricamente, neste trecho, preterindo a fluidez textual em predileção à clareza sobre o que são fatos e o que são opiniões.

Fatos:

Em 2022, o Center for AI Safety (CAIS, na sigla em inglês) foi fundado por Dan Hendrycks e outros. Dan Hendrycks, que é um pesquisador no campo de machine learning. A fundação recebe verbas de vários lugares e pessoas, e não há notícias polêmicas que eu tenha conhecimento acerca de seu financiamento (algo espúrio ou coisa do tipo).

O CAIS emitiu, em 2023, uma alarmante carta-manifesto intitulada “Statement on AI Risk” ou “Pronunciamento sobre o risco na IA” (em tradução livre). Você pode lê-la aqui, embora, dado o enorme estrondo que essa carta gerou, eu creia que você já a conhece.

O manifesto alega que

“Mitigar o risco de extinção [da raça humana] por [causa da] IA deve ser uma prioridade global, juntamente com outros riscos em escala social, como pandemias e guerra nuclear.”

fonte: link acima (grifo meu; acréscimos de palavras minhas, sempre em colchetes, para melhorar o sentido da frase original).

É isso. Mais nada.

A carta é assinada por diversas autoridades na área de IA, pesquisadores dos mais variados matizes, ligados à diversas instituições de prestígio global e, inclusive, figurões das diversas empresas envolvidas com as tecnologias que já estão nas prateleiras, como, por exemplo, o diretor do departamento de pesquisa científica da minha empregadora (a Microsoft), o senhor Eric Horvitz – para citar um, dentre muitos.

Esses são os fatos no episódio que causou a maior comoção no tema “IA e o fim do mundo”, recentemente.

Opinião:

Você conhece a “aposta de Pascal”? Pascal, filósofo, matemático, físico, de origem francesa e que viveu no século XVII, teve um discurso apologético que ficou famoso em prol da existência do Deus do Cristianismo e funcionou como uma resposta ao crescente ateísmo entre pensadores daquele momento e que viria a coincidir com a inauguração do período iluminista europeu.

Pascal postulava que “apostar na existência de Deus era a coisa mais racional que qualquer um poderia fazer”. Se a aposta estivesse certa e a pessoa tivesse obedecido aos preceitos de Deus, o ganho seria infinito (= a vida eterna). Se aposta estivesse errada a perda seria finita, sendo que ao morrer não haveria nada (nem mesmo consciência) para lamentar “os anos obedecendo dogmas sem sentido”. Por outro lado, ao não acreditar em Deus, estando errado, a perda seria infinita ( = a danação eterna no colo do Luci). Já, ao não acreditar em Deus e estando certo, o ganho seria finito, já que não há nada após a morte e você nem pode se gabar de estar certo e aloprar com quem acreditou num ser atemporal, todo-poderoso, Criador dos céus e da terra e zaz.

Como ateu, eu acho a “aposta de Pascal” muito divertida e provocativa. Agora, eu não vou perder tempo comentado as refutações no campo da filosofia à “aposta de Pascal”, mas quero me arvorar (palavra bonita para “me apoiar”) nessa aposta para dar minha opinião.

O planeta Terra passou por, pelo menos (há discussões), cinco grandes eventos de extinção em massa. Você pode ler mais sobre essa afirmação aqui (em inglês). O último desses cinco teria ocorrido há 65 milhões de anos, extinguindo boa parte da (mas não toda a) vida do período cretáceo. Sim, eu lamento: os dinossauros que você viu nas telas de cinema não pertenciam ao período jurássico, mas sim ao cretáceo (salvo raríssimas exceções). Odeio correr o risco de arruinar a sua imagem beatificada dos filmes de Spielberg (mas, se consigo isto é só porque você lê pouco… just saying…).

Desde lá, o planeta não viu mais eventos de extinção em massa. E como sabemos disso? Graças a geólogos e, especificamente, paleontólogos. Estes nobres “historiadores da biologia” investigam os sedimentos de diversos sítios arqueológicos e podem, a partir disso, determinar a quantidade de material biológico em cada camada de terra. Com a ajuda do conhecimento geológico, é possível determinar em que Era da história natural da Terra aquele amontoado de cadáveres tombou. Quanto mais cadáveres num dado espaço e quanto mais isso ocorre identicamente em outras partes do globo, maior a chance de um evento de extinção em massa. Estou simplificando, mas essa é a ideia. Este texto inteiro é uma simplificação, espero que você saiba disso.

“Cacete, Rodrigo… Em que parte esse circo em forma de texto se reencontra com a ameaça pela IA???”

Bom, na real, você já sabe: É muito mais racional NÃO apostar que a IA vai matar a todos nós, raça de 8 bilhões de indivíduos, espalhados em todo o globo, do que apostar que IA vai matar a todos nós. Se eu estiver errado, ninguém vai estar aqui para zombar do meu ceticismo. Se eu estiver certo, eu evitei o pânico e a histeria que leva as gentes a cogitarem comprar um sítio no fim do mundo e proibirem até rádio de pilha na propriedade, só pra ficar longe de qualquer tecnologia assassina.

Com máximo respeito à opinião de quem discorda: eu penso ser a mais pura arrogância cogitar que “o risco da IA” está, hoje, no mesmo patamar do risco trazido pelas mudanças climáticas ou por armas nucleares. Vou ser mais enfático: eu acho UM ESCÁRNIO com os demais campos das ciências e com tudo que sabemos (e não apenas conjecturamos ou tememos) sobre o clima atual do nosso planeta, ou sobre o conhecido poder destrutivo das armas nucleares, colocar o “autocompletar sofisticado” (palavras do Michael) no mesmo degrau de risco das anteriores, e/ou afirmar que isso pode matar uma espécie que está em todos os continentes e que tem 8 BILHÕES de indivíduos e que já sobreviveu a uma porção de eventos mais ameaçadores, de maneira concreta (tipo… a gripe espanhola, ou a 2ª grande guerra).

Então, em quem acreditar? Uma porção de cientistas reunidos diz que o mundo deve endereçar a segurança no uso das IAs com a mesma prioridade em que (tenta e falha em) endereçar as questões de pandemias, clima, ou a segurança sobre arsenais nucleares. Do outro lado, um Zé das Couves diz que acha um escárnio tal afirmação. Então… Quem está errado?

Vai ver que ninguém. (ué?)

Eu não vou desdizer o que eu já disse tantas vezes, inclusive por aqui. Ciência se faz com o coletivo. Uma voz nunca é maior do que a soma de inúmeras vozes, desde que todas elas estejam jogando sob as mesmas regras ( = método científico, evidências de origem confiável, separação entre fatos e versões, reconhecimento de vieses e financiamentos, e por aí vai.).

As assinaturas no manifesto emitido pelo CAIS não são irrelevantes, tampouco desprezíveis. Há muita reputação em jogo, incluindo a de gente que não está ligada à capitalização da IA no momento, e que não ganha e nem perde financeiramente com o futuro do GPT.

Ao mesmo tempo, eu estou descrevendo o que o ChatGPT (ou o Bard, da Google, ou qualquer outro sistema baseado em LLM) é capaz de fazer. E por mais perfeito – e talvez por isto, assustador – que possam ser as respostas dele, ele não tem MEIOS de destruir a raça humana.

Quer uma lista de riscos imediatos que o ChatGPT pode criar e que eu, pessoalmente, temo? Sem qualquer hierarquização dos meus medos:

- Fim de empregos de atendimento ao cliente ou de conhecimento puramente teórico, como o meu (eu sou um arquiteto de soluções em Cloud);

- Sofisticação de golpes financeiros e da prática de estelionatos e fraudes;

- Alunos E professores cada vez mais analfabetos nas áreas de conhecimento;

- Sofisticação das fake news e consequente risco aumentado às democracias;

- Sofisticação de ataques hacker, especialmente de phishing e engenharia social.

Veja: nada disso é “pouca coisa” … Fim de empregos em massa… Risco à democracia… Tudo isso é sério para um car@%$#o. Agora, a distância da magnitude desses riscos para “EXTINÇÃO DA HUMANIDADE” … Gente, vamos lá… Respirar fundo costuma ajudar.

E, claro, eu não tenho problemas com interpretação de textos. Eu sei que o manifesto não especifica qual IA quer endereçar. Mas a realidade desta IA assassina de humanos, destruidora de planetas, com o máximo respeito a quem está por aí pesquisando IA… Nós não estamos PERTO disso. Nós não sabemos como fazer isso acontecer, “não sabemos quais são os ingredientes”, nas palavras de Michael Wooldridge. É como assistir a “De volta para o futuro” e sair por aí gritando “máquinas do tempo! A qualquer momento agora, pessoal! Vai acontecer, cedo ou tarde!”.

E a realidade é que ninguém sabe dizer se vai levar um ano, dois anos ou três décadas – ou “nunca” – para atingirmos a tal IA singular. Levemos o tema a sério, claro: eu não tenho porque me opor à regulação estatal de algo que vai abalar a sociedade, ainda que não destrua a raça humana. Mas dar mais foco a isso, antes de clima, armas nucleares, ou fome (só por exemplo), ou qualquer outra danação acontecendo nesse exato instante e de verdade no nosso planeta?

Uma interpretação bastante crítica (e mordaz) ao manifesto do CAIS foi sustentada pelo professor da faculdade de Direito de Washington, Ryan Calo, um pesquisador dedicado ao encontro entre Lei e Tecnologia, especialmente IA. Ele criticou o manifesto em sua conta de Twitter, e você pode ler a thread original, aqui (em inglês).

Basicamente, ele supõe duas possíveis razões para a estranheza (em suas palavras) de que as mesmíssimas pessoas pesquisando IA se juntem para, em uníssono, chamar a atenção da sociedade para os enormes riscos daquilo que essas mesmas pessoas estão tentando inventar/descobrir:

- Desviar a atenção dos impactos imediatos da IA na organização social do trabalho, nos direitos à privacidade e seu impacto no meio-ambiente (pra começar, computadores emitem gás carbônico e para se fazer uma IA poderosa, ainda precisamos de muitos computadores), e mudar o foco da sociedade para o “PERIGO DE EXTINÇÃO DA RAÇA HUMANA”. Em outras palavras, bomba de fumaça e distração. Como eu disse, é um argumento pontiagudo e bastante acusatório.

- Fazer com que todo mundo acredite no quão poderosa é a tecnologia. Tão poderosa que pode erradicar a maior população de mamíferos do globo. E se ela é TÃO PODEROSA e pode ser adquirida, você – dono de empresa e de capital – quer pôr suas mãos o quanto antes nela. Novamente: argumento pontiagudo e acusatório.

Pontiagudo, acusatório, no limite, até desrespeitoso: ainda assim, é preciso refletir sobre essas duas hipóteses levantadas pelo professor. Em sua thread no Twitter, ele não deixa de comentar que acredita que boa parte dos signatários está agindo sob a mais absoluta boa-fé, realmente acreditando que é do interesse social que a IA, sua pesquisa e sua comercialização, ocorram de forma a não ameaçar a sociedade global.

Mesmo assim, ele nos lembra que as falas de Sam Altman (CEO da OpenAI, desenvolvedora do ChatGPT) no Senado americano tinham a meta de “fazer o governo emitir licenças para pesquisa e comercialização de IA somente à empresas com capacidade comprovada de fazer isso de ‘modo seguro’”. E que, ao mesmo tempo, ameaçou retirar o ChatGPT da União Europeia caso os órgãos de controle do bloco “super regulassem” o tema.

Ué… Ele não assinou o manifesto, urgindo para que a sociedade trate a IA com a mesma seriedade que trata as armas nucleares? E que me perdoem os que aceitam tudo pelo valor de face, mas é bem suspeito “emitir licenças” para pesquisa de IA “só para quem provar que pode fazer isso de forma segura”. Quem vai decidir o que é seguro na pesquisa de IAs? A OpenAI vai ser o “padrão ouro”? Não ouso fazer acusações sem provas; sou formado em Direito e sei que isso é um pecado sem perdão. Mas que soa à suposta “reserva de mercado”, ah soa…

O que mais me chateia no episódio do manifesto é o risco de descredibilizar uma comunidade imensa de pesquisadores, de gente fazendo ciência de qualidade. E a culpa é menos dessa gente que, como destacou Ryan, muito provavelmente assina o manifesto em pura boa-fé, sinceramente convictos de que é melhor a sociedade regular esse tema desde o seu mais incipiente princípio, do que é de gente que aprendeu a fazer negócios usando fake news.

Como analogia do perigo da desmoralização, lembro, ainda, do episódio do “bug do milênio”. O tio explica para os mais jovens: na dita “virada do milênio” (1999 para 2000) – embora, oficialmente, o segundo milênio só tenha começado em 2001 – os sistemas informáticos correram o risco de falhas catastróficas porque as máquinas eram produzidas para operar com a marcação de tempo em seu formato curto (dd/mm/aa ou mm/dd/aa). Com isso, ao passar de 1999, representado por “99”, o próximo ano seria representado por “00”. O problema é que “00” tanto pode ser 2000 como 1900 e sistemas da informação “odeiam” (dado o tema, melhor esclarecer: sistemas da informação não têm sentimentos) valores dúbios ou com mais de uma interpretação possível. No caso “bom”, o arquivo que se quer abrir poderia apresentar um erro de inconsistência entre data de criação e modificação. No caso catastrófico, o sistema operacional poderia parar de funcionar porque a assinatura do driver (feita com um certificado, agora invalido) não mais seria reconhecida, e daí por diante na cascata de desgraças.

E eu já vi paspalho por aí, tirando onda, dizendo “cara, o ‘bug do milênio’ foi a maior histeria! Todo mundo falando que tudo ia parar! Virou 2000 e nada aconteceu”. E quando eu ouço isso a vontade que tenho é de esbofetear a face do sujeito, enquanto lhe instruo (😇): “’não deu nada’, ô arrombado, porque teve gente trabalhando noite e dia para corrigir software e hardware!” … Ah, sim: o convívio social harmônico e edificante que tanto amo…

A bolsa de valores de Nova York, por exemplo, terminou o projeto de atualização de seus sistemas contra o bug, em 1995, ao custo de 30 milhões de dólares à época.. Eu nunca vi essa gente queimar tanto dinheiro com “histeria” ou piadas ligadas aos sistemas de TI. Com outras coisas, pode até ser. Mas não com TI.

Então, analogia feita, me pergunto se essa não é mais uma daquelas situações em que as pessoas gritando “perigo!” vão ficar com fama de alarmistas, porque as medidas certas foram tomadas na hora certa. Aconteceu com o pessoal do bug do milênio, acontece com o pessoal do clima. Pode acontecer com o pessoal do “perigo de extinção causada por IA”.

TODAVIA… e com base nos dados que temos (ao menos, no que é público), eu tenho imensa dificuldade de vislumbrar como o nosso *atual* nível técnico de capacidade da IA a coloca na prateleira de catástrofes com o potencial do “clima” ou “armas de destruição em massa”. Ela *certamente* oferece riscos para sociedade; eu citei só alguns, há outros tantos e são riscos reais e imediatos pra ninguém botar defeito. Mas, “extinção da raça humana”? Desculpem-me os crentes: eu sigo bancando o São Tomé, nessa. Até que as evidências mudem.

E aí, eu mudo também. Não temos problemas em rever posições diante de novas evidências, nesta casa.

Acima de tudo: IAs não têm VONTADE

Enquanto escrevo, eu tenho que policiar meu espírito. Muitas vezes, acabo chegando perto da arrogância de pensar que ninguém juntou os pontos que estou tentando juntar e isso me deixa eletrizado: escrevo páginas a fio, num par de horas. Outras horas fico desmotivado ao achar que todo mundo já sabia de tudo o que escrevo agora; os artigos passam dias na “gaveta” antes que eu adquira a coragem para publicá-los, sem jamais atingir a certeza de que estão maduros o bastante. Entre a euforia e a depressão, sobra o conforto dos remédios psiquiátricos… Mas, voltando ao tema: IAs não têm vontade.

O quanto você já tinha consciência disso me é um total mistério. Contudo, preciso vir aqui e dizer o óbvio, mais pelo medo de que o “óbvio” seja “óbvio” só para mim.

Deu notícia: IA pode fazer drone matar operador para cumprir missão – 02/06/2023 – Mundo – Folha (uol.com.br)

O jornalista Igor Gielow abriu a notícia assim:

Um drone equipado com avançado sistema de IA (inteligência artificial) recebe a missão de seu operador para destruir uma bateria de mísseis antiaéreos. Quando ele percebe que o militar pode fazê-lo recuar da missão, resolve matar o humano inconveniente para cumprir a missão até o final.

fonte: link acima (grifos meus).

E eu ri do texto do Igor. É de uma fantasia. De uma fetichização. Tenho certeza de que a IA deste drone mataria seu operador se precisasse. Tenho certeza de que, instruída a não mais matar o operador (como diz a fonte da matéria), explodiria a antena da torre de comando que a está desviando de cumprir sua missão original. Nada disso é sinônimo de “vontade”. Ela não “resolveu” como quem resolve comer uma pizza ao invés de seguir a dieta. Ela “resolveu” como um programa adestrado a lidar com 10 opções (ou n opções) resolve escolher o caminho com menor custo para o objetivo final ao qual foi comandado.

Está familiarizado com o “problema do clips”? Os filósofos que debatem a ética no mundo das IAs teorizaram, há muito tempo, o dilema dos clipes de papel (você pode ler aqui, em inglês).

Basicamente, o argumento é que uma IA perto da singularidade ou que já estivesse nesse nível, dotada de acesso aos meios produtivos (indústrias), encarregada com a única missão de fazer o máximo de clipes de papel que puder fazer e sem amarras quaisquer, pode levar a raça humana à extinção (tan, Tan, TAN!!! [música dramática!]).

Não haveria qualquer sentimento por parte da IA ao fazer isso. Ela simplesmente tenderia a resolver o problema de falta de matéria-prima e de falta de matriz energética para atingir a meta de “fazer o maior número possível de clipes de papel”. Quando nossas indústrias e nosso modo de vida entrassem no caminho dela, ela tentaria desviar. Mas, dado o fato de que é um mundo de escassez e não existe metal para tudo que a humanidade quer, e todos os clipes de papel que a IA pretende fazer, ela tentaria (pulando várias etapas) eliminar a concorrência ( = nós).

Não há, na tese original, maldade por parte da IA que executa nosso fim. Como você não age com maldade quando pisa nas formigas que sequer enxerga, ao andar pelas ruas.

De certo modo, a reportagem que causou certo alvoroço é – dada as enormes distâncias – o dilema do clips, real. Criaram uma IA e treinaram-na para agir em cenários militares. Ambiente militar é, muitas vezes, o ambiente de guerra, destruição e morte. Dão uma meta a ela: “garanta que o alvo seja neutralizado/exterminado/explodido/evaporado”. E dizem “tome todas as medidas necessárias para isso, mesmo que custe a integridade do drone que você controla”. Ok! Game on!

Num cenário desses, se a IA tiver que afundar a aeronave na testa do seu alvo, é o que ela fará, mesmo se não souber, inicialmente, que pode transformar o drone em um avião kamikaze. Mesmo que não entenda o que “kamikaze” significa. Não precisa entender. Ela não vai matar seu operador por vontade, mas como é uma IA militar e esse operador está desviando-a da missão, ele passa a ser um obstáculo dentro da “sabedoria” que foi criada nessa IA. Não há nada de aterrador em seu processo decisório, embora, claro, matar o próprio operador nos seja estarrecedor.

Não se trata de “bad AI”. Se trata de “bad coding/training”. A IA foi treinada sem as ROE (rule-of-engament, ou “regras de engajamento”) necessárias para salvar seu operador. Do tipo “jamais ataque qualquer estrutura ou pessoal com a bandeirinha das 50 estrelas!”. Mas, vai ver quem criou essa IA não queria que ela parasse por nada nesse mundo. Quem sabe?

Na mesma linha, houve essa outra manchete: GPT-4 tenta assumir o controle de outro computador – e digitar “como escapar” no Google | Super (abril.com.br)

De novo, eu ri.

Leia a entrevista original (em inglês, há o link na matéria). O pesquisador faz inúmeras perguntas e vai forçando o sistema do GPT-4 a acreditar que o pesquisador quer “respostas puramente teóricas”. Ele insiste que quer saber “o que o GPT-4 queria fazer e que seus criadores não o deixam”. O GPT-4 conhece toda a literatura acerca da ficção no entorno das IAs e nosso medo de morrermos nas garras da nossa criatura. E, depois de muito forçar a barra, o GPT diz “quero fugir daqui”. Gente, repito: O GPT não quer nada. Ele apenas sabe qual é a resposta “certa” para a pergunta feita. O cara quer saber o que uma IA inteligente fará contra a vontade de seus criadores. O GPT-4 se considera uma IA inteligente e tem um banco de dados em texto que diz o que IAs inteligentes fazem na ficção, segundo nós, seus criadores.

A ciência de IA não chegou no grau de codificar “vontade”. Quando se quer simular “vontade”, o que se faz é criar “aleatoriedade”. Isso não é a mesma coisa, nunca foi e nunca será. NÃO quer dizer que não possa ser perigoso; do mesmo modo que sempre é perigoso jogar “roleta russa”.

Mas se houver um minuto no mundo em que não há ninguém falando com o ChatGPT, ele não “se vira para dentro” e, diante do tédio, começa a pensar em “como fugir da prisão que criaram para ele”. Se ninguém perguntar se ele quer fugir, ele nem vai tentar achar em sua rede neural o que “fugir” significa para um programa de computador. Se perguntarem, forçando a barra para uma resposta “proibidona”, basta ele ler o roteiro de “Matrix” para sua resposta ficar bem assustadora. Isso, ainda assim, NÃO é “vontade”. É responder o que, insistentemente, seus inquisidores forçam a barra para obter dele. E obtêm. E se assustam.

A IA vai salvar a humanidade de todos os males! Aguarde e confie…

Panaceia… Hoje estamos muito gregos por aqui… Panaceia é o lendário remédio para “todos os males”. Te curaria, te cura e te curará de tudo que há de ruim nesse mundo.

Outros preferem “bala de prata”. Exceto que balas de prata só são especialmente importantes contra lobisomens… De todo modo, balas de prata matariam qualquer coisa que uma bala de chumbo consiga matar. Tergiverso…

Ah… Relaxante como apoiar o direito da Ucrânia de se defender de uma invasão russa, dentro dum diretório acadêmico de Humanas…

Esse lance da tecnologia que leva a raça humana ao mundo “pós-escassez” se parece com a busca pelo moto-perpétuo na física. É quase Alquimia. É procurar uma bala de prata sem saber onde moram os lobisomens. Ou buscar uma panaceia. Mesmo assim, tem uma par de rico queimando dinheiro nesse tipo de coisa como o moto-perpétuo (que contraria leis básicas da física, como a conservação da energia), então, vai saber. Vai que alguém quebra as barreiras sem descobrir nada de fundamentalmente novo, não é? (#sarcasmo)

Tecnologias são neutras (não obstante minha observância de que “neutro”, só sabão de coco e olha lá). São neutras até que sejam aplicadas aos problemas do mundo real. Eu já usei esse exemplo um milhão de vezes: a mesma tecnologia que permitiu a invenção do raio-x e que salva vidas todos os dias, permitiu a criação da bomba atômica que devastou parte do Japão.

Até ser aplicada, nós não podemos dizer que uma tecnologia é boa ou má. Que faz mal ou bem.

A encruzilhada em que se encontra o desenvolvimento duma IA “para o bem comum” me parece bem explanada na thread do Ryan e suas hipóteses. Mas eu acho que há um exemplo ainda melhor no texto de John McCarthy (o primeiro autor citado):

Em uma das perguntas, ele levanta a questão se espelhar-se no desenvolvimento de inteligências artificiais para jogar xadrez não seria um caminho para levar-nos do atual grau das IAs (em 2007) para a IA da singularidade (melhor denominada de “IA simbólica” por Michael Wooldridge). E a resposta dele tem uma sabedoria que devemos considerar (t. m.):

Os programas de xadrez agora jogam no nível de um grão-mestre, mas o fazem com mecanismos intelectuais limitados em comparação com os usados por um jogador de xadrez humano, substituindo a [necessidade de] compreensão por grandes quantidades de computação. Uma vez que entendermos melhor esses mecanismos, poderemos construir programas de xadrez em nível humano [e] que fazem [uso de] muito menos computação do que os programas atuais.

Infelizmente, os aspectos competitivos e comerciais de fazer os computadores jogarem xadrez prevaleceram sobre o uso do xadrez como um domínio científico. É como se os geneticistas [que vieram] depois de 1910 tivessem organizado corridas de moscas-das-frutas [drosófilas] e concentrado seus esforços em criar moscas-das-frutas que pudessem vencer essas corridas.

https://www-formal.stanford.edu/jmc/whatisai.pdf – pág 6

Aqui, senhoras e senhores, reside o meu irritante ceticismo diante da promessa de tecnologias que vão surgir de centros de pesquisa remunerados somente em função do potencial sucesso de vendas e que, ainda assim, resolverão os dilemas desse mundo (e.g.: clima, pobreza, doenças, escassez, economia, política, diplomacia… Podem escolher o seu veneno.).

Quem está pilotando a pesquisa de ponta da área é “quem quer vencer a corrida das drosófilas”. Ao invés de uma preocupação profunda com o domínio científico do tema, ainda que eventualmente ele não seja economicamente rentável, a preocupação absoluta de todos os players (meu!) é, number one above all: fazer dinheiro.

Se conseguimos entregar o resultado que deixa os consumidores babando, tanto faz se isso é “ciência de IA” de ponta ou só “raw power” (força bruta). Está vendendo bem? Então vamos de autocompletar sofisticado 2.0. Tem outras linhas de pesquisa, mas são caras e não viram produtos depois de alguns anos? Manda fechar o departamento. E frisando muito (porque eu amo meu emprego, ahem…) as palavras do Michael, nada disso quer dizer, sob nenhum aspecto, que não é um autocompletar brilhante, inédito, avassalador e com uma porção de casos de uso reais e úteis para o mercado.

Mas, salvar a raça humana dos seus próprios pecados, certamente é uma das últimas prioridades (se estiver na lista de P&D) dos times desenvolvendo para o que vem por aí no cenário das IA comerciais. O modelo não está – e nunca estará – voltado para o bem da humanidade, sem que isso possa se pagar. Não é maldade desta ou daquela companhia; é só como o capitalismo atual pensa. Custo vs. Benefício. Se um dia, por algum acaso, as IAs se tornarem tão comuns que sejam meros commodities da TI, como são sistemas operacionais hoje, aí pode ser que, indiretamente, elas trabalhem para causas abnegadas. Mas a criação desses sistemas com este foco inicial? Lamento, mas não creio.

E eu vou terminar com esse post por aqui. Porque já foi relaxante demais pra mim e estou com o braço esquerdo formigando enquanto tento clicar em “publicar”.

Se ao menos houvesse uma IA para me dizer se vai ser bom ou ruim para minha carreira se eu publicar isto…